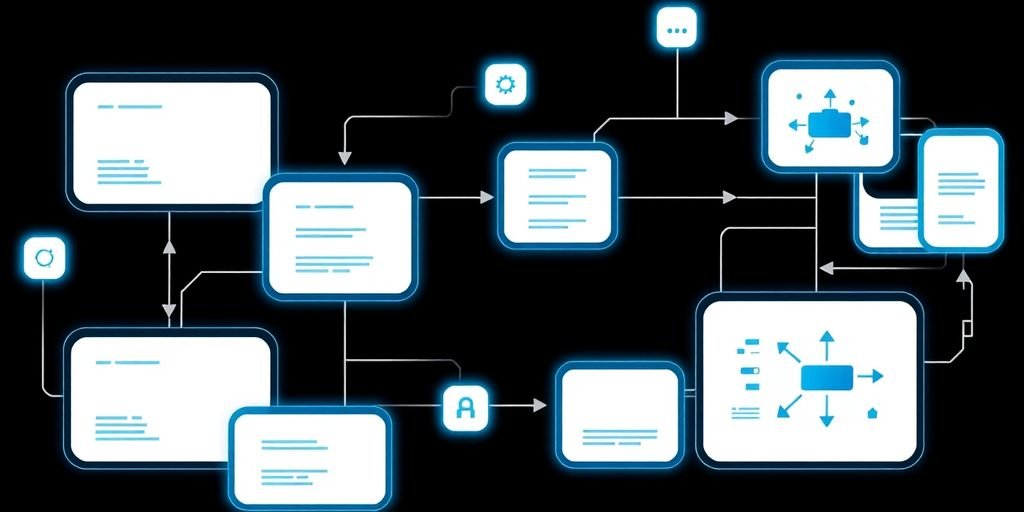

O artigo “Integração de Pipeline MLOps: Otimizando o Ciclo de Vida da IA” explora como integrar pipelines de MLOps pode melhorar a eficiência e a eficácia na implementação de soluções de inteligência artificial. Com o aumento da complexidade dos modelos de IA, a necessidade de uma abordagem estruturada para gerenciar seu ciclo de vida se torna cada vez mais importante. Vamos discutir os principais componentes, desafios e práticas recomendadas para uma integração bem-sucedida.

Principais Conclusões

- A integração de pipelines MLOps melhora a colaboração entre equipes de ciência de dados e engenharia de software.

- Automatizar processos de MLOps reduz erros e acelera a entrega de modelos em produção.

- Monitoramento contínuo é essencial para garantir que os modelos de IA mantenham seu desempenho ao longo do tempo.

- A adoção de ferramentas de controle de versão facilita a rastreabilidade e a reprodutibilidade dos modelos.

- A cultura organizacional deve apoiar a integração de MLOps para superar desafios e promover inovações.

Introdução à integração de pipeline MLOps

Definição de MLOps

MLOps é como a gente junta a ciência de dados com a engenharia e operações. É tipo uma ponte que conecta o desenvolvimento de modelos de machine learning com a implementação e monitoramento. Imagina só, criar modelos de IA e deixá-los rodando de boa, sem dor de cabeça.

Importância da integração de pipelines

Integrar pipelines é essencial porque ajuda a manter tudo organizado e funcionando. Sem isso, é fácil se perder no meio de tantos dados e modelos. Com um pipeline bem estruturado, a gente consegue automatizar tarefas e garantir que cada etapa do processo de desenvolvimento esteja alinhada com os objetivos do projeto.

Benefícios para o ciclo de vida da IA

Os benefícios são muitos: desde a redução de erros até a aceleração do tempo de entrega. Quando temos um pipeline bem integrado, podemos:

- Automatizar processos repetitivos, economizando tempo e esforço.

- Melhorar a qualidade dos modelos com feedback contínuo.

- Facilitar a colaboração entre equipes, já que todos estão na mesma página.

A integração bem-sucedida da IA com sistemas existentes é crucial para modernizar processos e melhorar a eficiência, apesar dos desafios de compatibilidade. É um processo contínuo de aprendizado e adaptação, essencial para o sucesso no longo prazo. Leia mais sobre a implementação bem-sucedida da IA.

Componentes essenciais de um pipeline MLOps

Gerenciamento de dados

Cuidar dos dados é onde tudo começa. Primeiro, coletamos os dados brutos de várias fontes, como bancos de dados e sensores. Depois, fazemos a limpeza e o pré-processamento, removendo erros e ajustando os dados para análise. É como preparar os ingredientes antes de cozinhar. O controle de versão é vital aqui, garantindo que podemos voltar atrás se algo der errado.

Desenvolvimento e treinamento de modelos

Aqui, desenvolvemos e treinamos nossos modelos de aprendizado de máquina. A fase de treinamento é onde o modelo aprende a partir dos dados. Testamos, ajustamos e repetimos até que o modelo esteja pronto para ser usado. Isso envolve muita experimentação e ajustes para obter o melhor desempenho possível.

Monitoramento e manutenção

Depois que o modelo está em produção, não podemos simplesmente deixá-lo lá. Precisamos monitorar seu desempenho continuamente. Isso significa ficar de olho em desvios, viés e outros problemas que possam surgir. Se algo estiver errado, devemos estar prontos para intervir e corrigir o curso. É como manter um carro em boa forma, sempre verificando se está tudo funcionando bem.

Automação no MLOps

Pipelines de CI/CD

Nosso foco aqui é integrar o pipeline de aprendizado de máquina aos pipelines de CI/CD já existentes. Isso significa que cada mudança no modelo ou nos dados pode ser automaticamente testada e implementada, garantindo que o modelo esteja sempre atualizado e funcionando da melhor forma.

Automação de re-treinamento de modelos

Com a automação, podemos agendar re-treinamentos de modelos quando novos dados estão disponíveis ou quando o desempenho do modelo cai abaixo de um certo nível. Isso garante que o modelo continue relevante e preciso sem a necessidade de intervenção manual constante.

Integração contínua e entrega contínua

A integração contínua e entrega contínua (CI/CD) no MLOps é como ter uma linha de montagem bem lubrificada. Tudo flui de maneira mais suave, desde a codificação até a implementação. Isso não só melhora a eficiência, mas também a qualidade dos modelos, reduzindo o tempo de colocação no mercado.

A automação no MLOps não é apenas sobre eficiência; trata-se de criar um sistema onde cada parte do processo de aprendizado de máquina se integra perfeitamente, permitindo que as equipes se concentrem no que realmente importa: inovação e melhoria contínua.

Desafios na implementação de MLOps

Cultura organizacional

Implementar MLOps não é só sobre tecnologia, mas sobre pessoas também. Cada equipe dentro da empresa, como ciência de dados, desenvolvimento e operações, tem suas próprias metas e jeitos de fazer as coisas. Fazer todo mundo trabalhar junto pode ser complicado. É tipo tentar juntar um time de futebol onde cada um quer jogar de um jeito diferente. Pra isso funcionar, a empresa precisa mudar a forma como todo mundo pensa e age, adotando novas práticas e processos.

Integração de equipes multidisciplinares

Outra coisa complicada é integrar equipes que têm conhecimentos bem diferentes. Cientistas de dados, engenheiros de software e pessoal de TI precisam trabalhar juntos, mas cada um fala uma "língua" diferente. É como colocar um chef de cozinha, um engenheiro civil e um médico pra resolver um problema juntos – todo mundo tem que aprender a se entender e colaborar. Isso demanda paciência e esforço.

Superação de barreiras técnicas

E claro, tem os desafios técnicos. Automatizar todo o processo de MLOps, desde a coleta de dados até a implementação do modelo, pode ser uma dor de cabeça. É preciso lidar com dados bagunçados, escolher os algoritmos certos e garantir que tudo funcione bem junto. Além disso, em ambientes com muitas regras e regulamentos, como bancos ou hospitais, a segurança e a privacidade dos dados são super importantes e podem complicar mais ainda as coisas.

Implementar MLOps é como montar um quebra-cabeça gigante, onde as peças são pessoas, processos e tecnologia. Cada peça tem que se encaixar direitinho para que tudo funcione bem. É um desafio, mas quando dá certo, os benefícios são enormes.

Ferramentas e tecnologias para MLOps

Controle de Versão e Colaboração

- Git é a ferramenta que usamos para controlar as versões do nosso código. Com ele, podemos acompanhar cada mudança feita e voltar atrás se necessário. É tipo um "Ctrl+Z" para o código.

Orquestração de Contêineres

- Com o Docker, a gente empacota nossas aplicações em contêineres, o que facilita muito a distribuição e a execução em diferentes ambientes.

- Já o Kubernetes é o cara que gerencia esses contêineres. Ele cuida da escalabilidade e da disponibilidade, garantindo que tudo continue rodando mesmo se alguma coisa der errado.

Monitoramento e Logging

- Para monitorar o desempenho dos nossos modelos, usamos o Prometheus. Ele coleta métricas e nos avisa se algo sair dos trilhos.

- O Grafana entra em cena para nos ajudar a visualizar essas métricas. Com ele, criamos painéis bonitos e fáceis de entender, mostrando como nossos modelos estão se comportando.

"Escolher as ferramentas certas é como montar uma banda: cada instrumento tem seu papel e juntos fazem a música fluir."

Essas tecnologias são apenas algumas das muitas que podemos usar no MLOps. A ideia é combinar o que funciona melhor para o nosso time e projeto, sempre de olho na eficiência e na facilidade de integração. Com as ferramentas certas, a gente consegue focar no que realmente importa: melhorar nossos modelos e entregar resultados incríveis.

Práticas recomendadas para MLOps

Ciclos de feedback e melhoria contínua

Bom, a gente sabe que não dá pra deixar um modelo de machine learning rodando eternamente sem ajustes. Modelos precisam ser revisados e atualizados pra continuar dando bons resultados. Por isso, é essencial ter ciclos de feedback bem definidos. Isso ajuda a manter o modelo sempre afinado com as mudanças no ambiente de produção.

Gerenciamento de versões de modelos

Manter controle sobre as versões dos modelos é super importante. Isso significa ter um histórico claro de todas as alterações feitas, permitindo que a gente volte para uma versão anterior se algo der errado. Sem isso, fica um caos saber qual modelo tá rodando e quais ajustes foram feitos.

Garantia de qualidade e testes

Antes de colocar qualquer modelo em produção, é fundamental garantir que ele foi bem testado. Testes rigorosos ajudam a evitar surpresas desagradáveis depois que o modelo já está em uso. É como revisar uma prova antes de entregar, sabe? Melhor prevenir do que remediar.

Implementar essas práticas não só melhora a eficiência dos nossos projetos de machine learning, mas também garante que estamos sempre prontos para nos adaptar às mudanças e desafios que surgem ao longo do caminho.

Integração de MLOps com DevOps

Semelhanças e diferenças

Quando falamos de MLOps e DevOps, estamos basicamente discutindo como integrar duas áreas que, à primeira vista, têm muito em comum, mas no fundo, têm suas peculiaridades. Ambos compartilham a ideia de automação e entrega contínua. DevOps foca em integrar desenvolvimento e operações para melhorar a entrega de software, enquanto o MLOps vai um passo além, incluindo o gerenciamento de dados e modelos de machine learning. Uma diferença chave é que o MLOps precisa lidar com a variabilidade dos dados e a necessidade de re-treinamento de modelos, algo que não é uma preocupação para o DevOps.

Benefícios da integração

Integrar MLOps com DevOps pode trazer uma série de vantagens. Primeiro, podemos acelerar o tempo de colocação no mercado dos nossos produtos de IA, já que a automação reduz os gargalos. Segundo, a integração melhora a colaboração entre as equipes, quebrando silos que tradicionalmente separam desenvolvedores, cientistas de dados e operações de TI. Por último, essa união nos ajuda a manter a qualidade e a consistência dos modelos, pois temos um processo contínuo de monitoramento e ajustes.

Casos de uso bem-sucedidos

Existem várias empresas que já colhem os frutos dessa integração. Por exemplo, algumas companhias de tecnologia adotaram práticas de MLOps integradas ao DevOps para suas plataformas de recomendação, resultando em melhorias significativas na personalização e satisfação do cliente. Em outras palavras, ao unir as duas abordagens, conseguimos não só acelerar o desenvolvimento, mas também garantir que os modelos de IA sejam sempre relevantes e precisos. Isso é essencial para manter a competitividade no mercado atual.

Impacto da IA generativa no MLOps

Desafios específicos da IA generativa

A IA generativa está mudando o jogo no MLOps, mas traz alguns desafios. Primeiro, garantir que os modelos sejam interpretáveis e confiáveis é crucial. Precisamos entender como eles tomam decisões e mitigar qualquer viés que possa surgir. Outro ponto é a transparência dos modelos, que ainda é uma questão em aberto.

Adaptação de pipelines existentes

Para integrar a IA generativa, precisamos ajustar nossos pipelines. Isso significa atualizar as etapas de preparação de dados e talvez até automatizar algumas delas, como a limpeza de dados. A ideia é que a IA generativa possa melhorar a eficiência, permitindo que os cientistas de dados se concentrem em tarefas mais estratégicas.

Exemplos de aplicação

Existem muitos casos de uso promissores. Por exemplo, a IA generativa pode ajudar na criação automática de modelos de aprendizado de máquina. Isso não só acelera o desenvolvimento, mas também ajuda na avaliação rápida desses modelos. Outro exemplo é a automação de tarefas repetitivas, liberando tempo para que as equipes se concentrem em inovação.

A IA generativa tem o potencial de transformar o MLOps, mas, como toda tecnologia emergente, vem com seu próprio conjunto de desafios e oportunidades. Precisamos estar preparados para adaptar nossos processos e garantir que estamos usando essa tecnologia de maneira responsável.

Futuro do MLOps e tendências emergentes

Evolução das práticas de MLOps

O MLOps está sempre mudando. A gente vê que a automação completa do ciclo de vida dos modelos de aprendizado de máquina vai crescer. Isso vai ajudar empresas a economizar tempo e recursos.

Inovações tecnológicas

A gente espera ver mais plataformas de nuvem sendo usadas. Elas são legais porque oferecem escalabilidade e segurança. Além disso, a integração de DevOps com MLOps vai ficar mais comum, facilitando o controle de tudo num só lugar.

Previsões para o futuro

O uso de modelos generativos vai aumentar. Muitas empresas já planejam usar esses modelos. A colaboração entre equipes de dados, TI e operações também vai ser prioridade. Assim, todo mundo trabalha junto de forma eficiente.

No futuro, a integração de soluções de IA vai ser essencial para enfrentar desafios técnicos e de gestão. A gente precisa se adaptar rápido para continuar competitivo.

Casos de sucesso na integração de MLOps

Empresas líderes no uso de MLOps

Vamos falar sobre algumas empresas que estão mandando bem na integração de MLOps. Primeiro, temos uma gigante do e-commerce que conseguiu melhorar suas recomendações de produtos usando modelos de machine learning. Eles integram esses modelos com suas plataformas existentes, o que resultou em uma experiência de usuário mais personalizada e um aumento nas vendas. Outra empresa, no setor financeiro, conseguiu detectar fraudes de maneira mais eficiente ao integrar IA em seus sistemas de análise de transações. Esses exemplos mostram como o MLOps pode trazer resultados impressionantes.

Resultados alcançados

Os resultados? Vamos lá. A empresa de e-commerce viu um aumento de 30% nas conversões de vendas, enquanto o banco reduziu a fraude em 25%. Esses números são significativos e mostram o impacto direto da integração de MLOps nos negócios. Em ambos os casos, a chave foi a integração contínua e a entrega contínua de modelos de IA, garantindo que estivessem sempre atualizados e alinhados com as necessidades do mercado.

Lições aprendidas

O que aprendemos com esses casos? Primeiro, a importância de uma boa orquestração de contêineres para gerenciar recursos de forma eficiente. Segundo, a necessidade de monitorar e ajustar continuamente os modelos para evitar que se tornem obsoletos. E, claro, a colaboração entre equipes de TI e negócios é essencial para o sucesso. Sem isso, as iniciativas de MLOps podem falhar.

Nota: A integração de MLOps não é uma solução mágica, mas com a estratégia certa, pode transformar a forma como as empresas operam, trazendo inovação e eficiência.

Na seção "Casos de sucesso na integração de MLOps", você vai descobrir como empresas transformaram seus desafios em grandes conquistas. Se você também quer ver sua empresa prosperar com soluções de inteligência artificial, não perca tempo! Visite nosso site e agende uma conversa com nossos especialistas para saber mais!

Conclusão

A integração de pipelines MLOps é fundamental para otimizar o ciclo de vida da inteligência artificial. Ao unir práticas de desenvolvimento e operações, as empresas conseguem não apenas acelerar a entrega de soluções, mas também garantir a qualidade e a confiabilidade dos modelos de IA. Essa abordagem colaborativa permite que equipes de diferentes áreas trabalhem juntas, promovendo uma cultura de inovação e eficiência. Com a automação e a monitorização contínua, é possível identificar e corrigir problemas rapidamente, assegurando que os modelos se mantenham relevantes e eficazes. Assim, a implementação de MLOps não é apenas uma tendência, mas uma necessidade para qualquer organização que deseja se destacar no competitivo mundo da inteligência artificial.

Perguntas Frequentes

O que é MLOps?

MLOps é uma prática que combina Machine Learning e operações para tornar o desenvolvimento e a implementação de modelos de IA mais eficientes.

Por que a integração de pipelines é importante?

Integrar pipelines ajuda a melhorar a colaboração entre equipes e a acelerar o ciclo de vida dos projetos de IA.

Quais são os principais componentes de um pipeline MLOps?

Os componentes incluem gerenciamento de dados, desenvolvimento de modelos, monitoramento e manutenção.

Como a automação ajuda no MLOps?

A automação permite que tarefas repetitivas sejam feitas de forma rápida e precisa, liberando tempo para inovações.

Quais são os desafios ao implementar MLOps?

Os desafios incluem a mudança na cultura organizacional e a necessidade de colaboração entre equipes diferentes.

Que ferramentas são usadas em MLOps?

Ferramentas comuns incluem Git para controle de versão, Jenkins para automação, e Docker para contêineres.

Como garantir a qualidade dos modelos em MLOps?

A qualidade é garantida através de testes, monitoramento contínuo e ciclos de feedback.

Qual é o futuro do MLOps?

O futuro do MLOps envolve a adoção de novas tecnologias e práticas que tornam a IA mais acessível e eficiente.